С операционной точки зрения, мы можем определить алгоритм, как конечную последовательность команд, использующих исходные данные для получения результата. С функциональной точки зрения это отображение , где - входные данные - элемент результирующего множества.

О-нотация

Одну и ту же задачу зачастую можно решать большим количеством различных способов, сильно отличающихся друг от друга. Но как оценить это решение? Есть ли способ определить, лучше оно или хуже остальных и насколько?

Допустим, мы уже разработали некий АбстрактныйАлгоритм. Если мы его запустим, но можем узнать:

- Насколько долго он работал(обозначим как )

- Сколько памяти использовал(обозначим как )

- и т.д.

Может показаться, что этого достаточно, но мы решили отправить АбстрактныйАлгоритм нашему АбстрактномуДругу, у которого компьютер намного хуже нашего. И оказалось, что то, что у нас занимало 1 минуту, у АбстрактногоДруга занимает 2 часа.

Мы хотим избежать подобных проблем. Поэтому решаем оценивать наш АбстрактныйАлгоритм не с секундомером, а по количеству операций(абстрактных).

Рассмотрим небольшую функцию из алгоритма.

Haskell:

exists :: [Int] -> Int -> Bool

exists (h:_tail) tgt = findElement _tail tgt $ (h == tgt)

exists x target = (x == tgt)

Python:

def exists(arr, tgt):

for e in arr:

if e == tgt:

return True

return False

Разбор примера и определения

Видим, что функция просто проверяет, есть ли элемент в массиве. Посчитаем, сколько операций для этого требуется(с учётом того, что размер нашего массива ):

- В худшем случае операций для обхода массива()

- В худшем случае операций сравнения()

- Одна операция возврата результата()

В сумме получили: операций. Обратим внимание на фразу в худшем случае. Под этим мы подразумеваем, что количество операций может быть меньше, но, например, в случае, когда - последний, нам потребуется именно столько операций. Для удобства обозначают . Для операции возврата значения нам всегда требуется одна операция(и в худшем и в лучшем случае). Для лучшего случая есть обозначение . А если и , то .

Теперь обобщим результат из нашего пример. Получим: .

Заметим ещё одну деталь. Нам нужно знать, сколько операций требуется для вычисления не только на фиксированном размере массива, намного интереснее знать, как растёт сложность нашего алгоритма при росте (будем называть это число размером входа).

Выражение сейчас не является для нас чем-то удобным, так как мы не можем производить над ним какие-то операции. Для решения этой проблемы формализуем наши определения:

: Пусть, начиная с некоторого размера входа сложность нашего алгоритма меньше или равна некоторой другой сложности , умноженной на какую-то константу . Тогда

Запишем это выражение ещё более формально: Пусть тогда такие что

: Пусть, начиная с некоторого размера входа сложность нашего алгоритма больше или равна некоторой другой сложности , умноженной на какую-то константу . Тогда

:

Из определения выходит, что:

Вернёмся к нашему выражению и упростим его: То есть теперь мы можем сказать, что АбстрактныйАлгоритм выполняется за линейное время или

Резюмируем

На данный момент мы можем написать некоторый АбстрактныйАлгоритм, измерить его сложность при помощи и , а потом отправить АбстрактномуДругу и быть уверенным, что у него всё будет работать также хорошо, как и у вас.

Мастер-теорема

Мы уже умеем измерять сложности. Но что делать, если алгоритм рекурсивный? Мы ведь не можем так просто посчитать все возможные операции? Или всё-таки можем...

Немного изменим наш пример:

Haskell:

split :: [a] -> ([a], [a])

split l = splitAt (((length l) + 1) `div` 2) l

exists :: [Int] -> Int -> Bool

exists [x] tgt = x == tgt

exists arr tgt = uncurry (\x y -> (exists x tgt) || (exists y tgt)) (split arr)

Python:

import math

def exists(arr, tgt):

length = len(arr)

if length == 1:

return arr[0] == tgt

sep_id = math.ceil(length/2)

return exists(arr[:sep_id],tgt) or exists(arr[sep_id:],tgt)

Теперь мы рекурсивно ищем элемент в правом и левом поддереве, пока длина массива не будет равна 1.

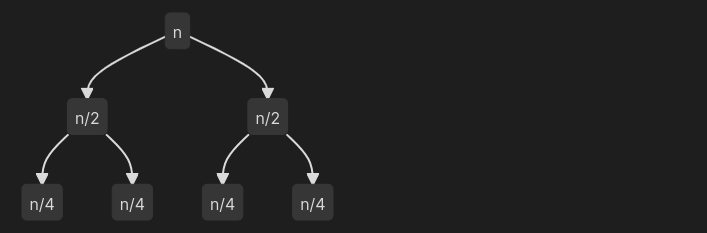

Рассмотрим часть соответствующего дерева рекурсивных вызовов.

Видим, что размер входа на каждом последующем уровне становится в 2 раза меньше. Получается, что на уровне(с нуля) размер входа для одного вызова будет равен: При этом сложность суммарно на уровне будет: А количество уровней будет равно , т.е для - 3 уровня, для - 4 уровня и т.д.

Для того, чтобы найти общую сложность алгоритма, просуммируем по всем уровням:

Отсюда получается, что наш рекурсивный алгоритм также эффективен, как и его нерекурсивный аналог из предыдущего раздела.

Теперь, используя похожие умозаключения, сформулируем теорему, которая позволит оценить не только эту, но и многие другие рекурсивные задачи.

Теорема:

,где - кол-во подзадач, - размер подзадачи, - нерекурсивная сложность(сравнения, присваивания и т.д.)

Док-во: Как и в примере выше найдём суммарную сложность для всех уровней. Сложность одного вызова: Сложность суммарно на уровне: Суммарная сложность:

Подставим получившийся результат в выражение системы:

Результат полученного выражения зависит только от : Получаем всего 3 случая:

- :

- :

- :

Резюмируем

Для рекурсивной подзадачи вида: Сложность будет равна:

Вернёмся к нашему примеру и оценим его с помощью теоремы:

Т.к. , то , что подтверждает нашу оценку выше.